EFF:「AppleのCSAM検出機能はバックドアであることは変わりなく、より広範な悪用への道を開いてしまうことになる」

Appleがアナウンスした、iCloud Photosに含まれるChild Sexual Abuse Material(CSAM)コンテンツを検出する機能について、The Electronic Frontier Foundationは「Apple’s Plan to “Think Different” About Encryption Opens a Backdoor to Your Private Life」で以下のような見解を示していました。

児童搾取は深刻な問題であり、アップルはそれに対抗するためにプライバシー保護の姿勢を曲げた最初のハイテク企業ではありません。

しかし、その選択は、ユーザーのプライバシー全体にとっては高い代償となるでしょう。

Apple社は提案しているバックドアにおいて、その技術的な実装がいかにプライバシーとセキュリティを保護するかを長々と説明することができますが、結局のところ、徹底的に文書化し、慎重に検討された狭い範囲のバックドアであっても、それがバックドアであることに変わりはありません。

(中略)

エンド・ツー・エンドの暗号化に関するアップル社の妥協は、米国内外の政府機関にとっては好都合かもしれませんが、プライバシーとセキュリティにおけるアップル社のリーダーシップに信頼を寄せてきたユーザーにとっては、衝撃的な方向転換となります。

他のセキュリティ関係者からの懸念と同じように、EFFの見解としては、バックドアをシステムに内包することにより、より広範な悪用への道を開いてしまうことを問題視しています。

現在もいくつかの国では、メッセージの出所を特定し、コンテンツを事前に審査するという要件が含まれている法律があり、今回のAppleの変更により、エンド・ツー・エンドのメッセージングサービスにおいて、このようなスクリーニング、テイクダウン、報告が可能になり、例えば、LGBTQ+を禁止している政府が検閲し処罰を行うためのツールとして悪用することになる可能性も容易に考えられるとしています。

これはLGBTQ+だけでなく、ある国の政府が好まない表現を内包した写真をユーザーが持っている場合に検閲する、といった目的にはとても便利なツールということにもなります。

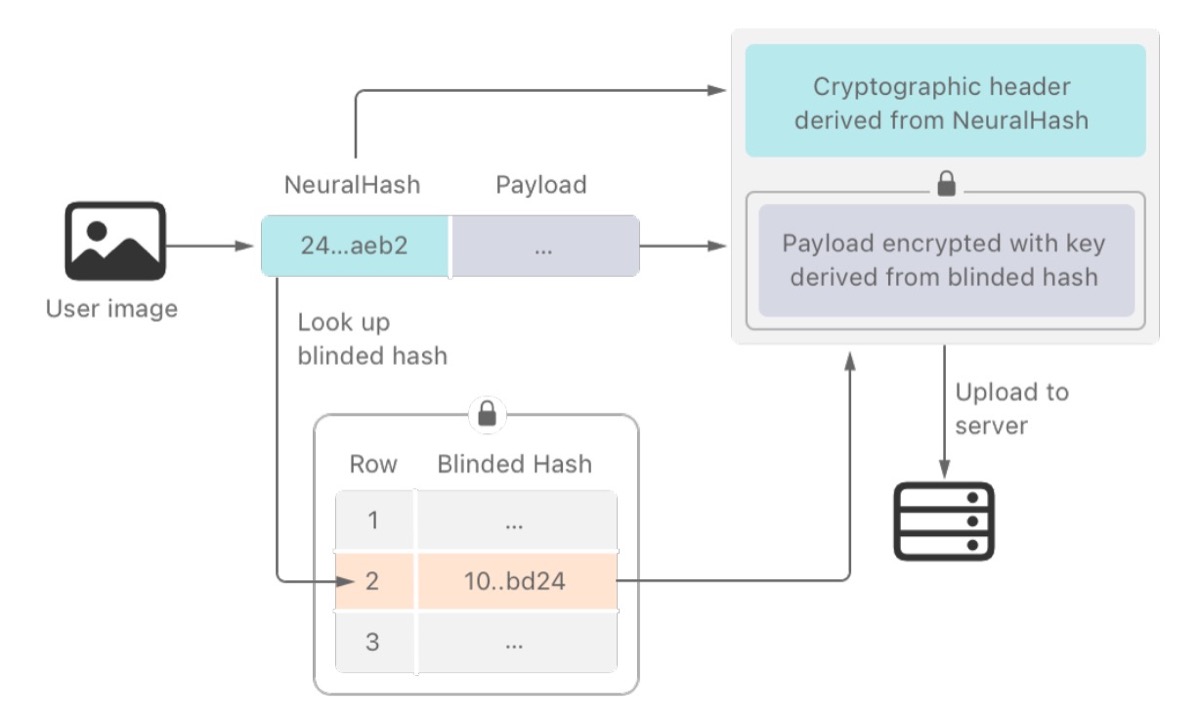

CSAM Detection Technical Summary

Electronic Frontier Foundationはデジタルの世界で市民の自由を守る非営利団体として1990年に設立。

政策分析、草の根活動、技術開発、インパクトのある訴訟を通じて、ユーザーのプライバシー、表現の自由、イノベーションを保護することを目的としています。

なお、Appleは今回のCSAM検出機能のアメリカ以外の国での展開については、現地の法律や規制に応じて国ごとに行うと9to5Macに回答しているそうです。

また、CSAM検出機能を追加の国に拡大する時期やその可能性について、具体的なスケジュールなどは明らかにされていません。

Apple says any expansion of CSAM detection outside of the US will occur on a per-country basis – 9to5Mac